当主角学会了七肢桶的语言后,就觉醒了时空意识。这也是为什么她会对女儿的死无动于衷,因为所有的事情都会发生,你只是观察到了时空的一个切面。

但这并不是说平行时空或世界线,因为不同事件的发生概率是不一样的。这个概率不是用来区分必然性和偶然性(所有事情都是必然),而是用来计算和结局的相似度,最相似的概率会作为过程显现出来。光会遍历所有的路径,但是你只能观测到最短路径。然而它确实遍历了所有的路径,因为你能观测到干涉现象。

电影《降临 Arrival》是完全背离了原著的内涵的,如果你要理会我在这里探讨的事情,需要阅读一下原著,而不是电影。我曾经对电影写过一篇恶评: https://movie.douban.com/subject/21324900/

next: https://t.me/laiskynotes/149

https://laisky.notion.site/Aligning-language-models-to-follow-instructions-0a1a1aca07174ad09b1cee55d4856b4f?pvs=4

经常在大模型领域听到 aligning(拉通对齐)这个词,此文就介绍了究竟是什么意思。

这个对齐指的是让 LLM 的输出,和用户的期望对齐。这是个很宽泛的描述,包括:

1. 遵循用户的指令

2. 遵循事实

3. 不要包含恶意信息

而实现对齐的方法为:

1. 找一群活人充当 labelers,编写参考回答,同时也为模型输出评分

2. 用 labelers 编写的回答来 fine-tuning 模型

3. 用 labelers 的打分数据,去训练一个 Reward Model

4. 用 Reward Model 对 LLM 进行强化学习

这套流程称为真人反馈强化学习(reinforcement learning from human feedback, RLHF)

最终得到的新模型,称为 InstructGPT,这个模型可以用缩小 100 倍的参数量,实现更好的输出。

GPT-3 本来有 175B 个参数,而 InstructGPT 只有 1.3B。这就是为什么 GPT 可以实现性能飞跃和大幅降价的原因,也就是后续的 turbo 模型。

Ps. 奇了怪了,我记得去年 Azure 透露 GPT 只有 2B 参数时还有一大群人震惊,其实 OpenAI 在这篇 2022 年 1 月的文章里就说了只有 1.3B 参数。

经常在大模型领域听到 aligning(拉通对齐)这个词,此文就介绍了究竟是什么意思。

这个对齐指的是让 LLM 的输出,和用户的期望对齐。这是个很宽泛的描述,包括:

1. 遵循用户的指令

2. 遵循事实

3. 不要包含恶意信息

而实现对齐的方法为:

1. 找一群活人充当 labelers,编写参考回答,同时也为模型输出评分

2. 用 labelers 编写的回答来 fine-tuning 模型

3. 用 labelers 的打分数据,去训练一个 Reward Model

4. 用 Reward Model 对 LLM 进行强化学习

这套流程称为真人反馈强化学习(reinforcement learning from human feedback, RLHF)

最终得到的新模型,称为 InstructGPT,这个模型可以用缩小 100 倍的参数量,实现更好的输出。

GPT-3 本来有 175B 个参数,而 InstructGPT 只有 1.3B。这就是为什么 GPT 可以实现性能飞跃和大幅降价的原因,也就是后续的 turbo 模型。

Ps. 奇了怪了,我记得去年 Azure 透露 GPT 只有 2B 参数时还有一大群人震惊,其实 OpenAI 在这篇 2022 年 1 月的文章里就说了只有 1.3B 参数。

有兴趣的话可以评论区讨论。

这不是民科,而是基于所有已知科学理论和事实,对未知进行的合理推测。

实际上我认为这是除了照顾好自己外最重要的事情,寻求对宇宙的理解。

---

无论是量子世界的叠加态,还是费曼的路径积分,似乎都预示了这么一个世界:

一切可能发生的事情都会发生,结果赋予过程以意义,事件概率不是发生的概率,而是其显现的概率。

所以观察者对于世界是无关紧要的,观察者只是让世界以观察者的方式现形。

---

所以你犹豫或者焦虑一件事要不要发生是没任何意义的,所有的事情都会发生。

光永远走最短路径,不是长的路径它不走,其实光遍历了所有的路径,不然双缝干涉就不会存在。

所有的事件都会发生,但是在某一时刻只有一个事件会显形,这是由观察者的结局反推回去的所有的概率重合事件。

---

人们喜欢说“经历比结果重要”。

但是这个世界的物理基础不是这样的,经历是最不重要的,你其实经历了一切。结果是唯一重要的,一切的经历都是从结果反推而呈现的。

宇宙的观察者毫无意义,哪怕不同的观察者看到了完全不同的宇宙,宇宙也还是那个宇宙。

---

能量在空间上展开时会出现对称性破损,构成基本力和物质。

物质在时间上展开时也会出现对称性破损,成为热力学第二定律。

意识的存在意义是在无所不包的时空混沌中勾勒出一条轨迹。意识的某个必然结局可以反推出一整个发展轨迹。

一个水分子在海洋中的路径,这就是你我全部的人生。

---

产生了一个奇思妙想:

给一个物体施加加速度,可以阻碍它在时间上的展开程度,因为它在一段连续的时间内都持续获得能量。

这在宏观上就表现为时间压缩,持续获得加速度的物体的时间流逝会比其他物体更慢一些。

毕竟时间根本就不存在,只是意识的存在性幻觉。意识就是时间的方向性的表现形式。

next: https://t.me/laiskynotes/147

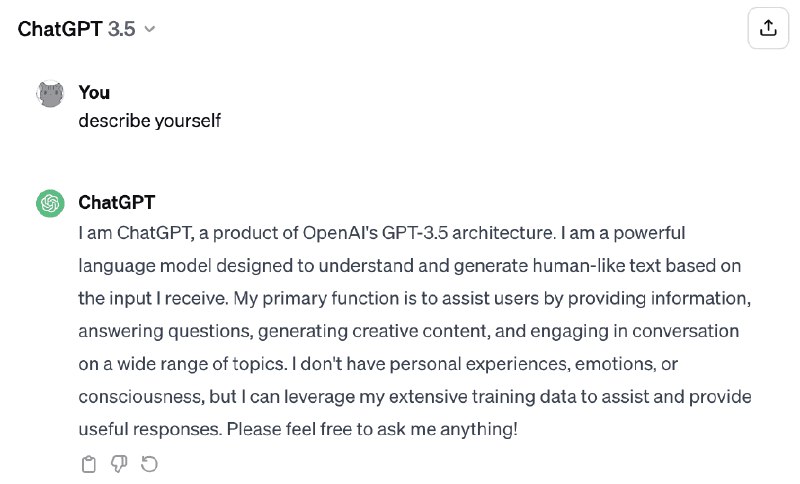

最近几天都在读这篇文章,作者是大名鼎鼎的 Stephen Wolfram,就是创建数学软件 Wolfram 的那位。

此文从 GPT 开始谈起,实际上回溯了神经网络的主线发展历程,从最基础的权重计算,讲到 n-grams 最终到 transformer 的 attention 机制。

虽然我多年前就学习过神经网络,但是有很多细节更多的是知其然不知其所以然,这篇文章读来让我有醍醐灌顶的感觉,把关键的部分的意义都讲清楚了。

作者还很清晰地阐述了神经网络的几个天然局限,这是人脑能轻松做到而神经网络只能望洋兴叹的:

1. 神经网络不是图灵机,没有计算能力,无法准确地完成任何计算步骤

2. 世界是无穷复杂的(irreducible computation、NP 复杂度),而人类的理论都是简化的近似。AI 只能通过人类的简化理论来学习。

但是这些局限并不是不可逾越的,比如 function calling 就赋予了 AI 图灵机的能力。

关于第二点,涉及到 Polany's Paradox,人类无法描述世界的复杂性。这至少有两个理解方式:

1. 人类的语言没有客观标准,其意义由社会共识所决定

2. 世界的复杂性无法被理论描述

所以,GPT 的成功,实际上并不预示着计算能力的重大进步,而是人类能力的“巨大退步”。GPT 用事实证明了人类的语言能力并不是 irreducible computation,而是背后存在一些简单的规则,而且这个规则被 GPT 学会了。

然而作者也提到,GPT 的技术进步某种程度上只是无数人不断尝试的结果,人们发现通过一些设计能得到更好的结果。但是为什么要这么设计,GPT 是如何理解的?人们仍然一无所知。与其说人们发明了 GPT,也许说人类发现了 GPT 更为合适。

作者还试图构建一个大一统的计算语言,来抽象一切的事物,同时赋予 GPT 可解释性。我直观上觉得,这是否就是当年罗素的分析逻辑?

整理了一篇博客文章: https://blog.laisky.com/p/what-is-gpt/

原文笔记: https://laisky.notion.site/What-Is-ChatGPT-Doing-and-Why-Does-It-Work-6d390e2e44eb40498bd8b7add36bcc94?pvs=4

此文从 GPT 开始谈起,实际上回溯了神经网络的主线发展历程,从最基础的权重计算,讲到 n-grams 最终到 transformer 的 attention 机制。

虽然我多年前就学习过神经网络,但是有很多细节更多的是知其然不知其所以然,这篇文章读来让我有醍醐灌顶的感觉,把关键的部分的意义都讲清楚了。

作者还很清晰地阐述了神经网络的几个天然局限,这是人脑能轻松做到而神经网络只能望洋兴叹的:

1. 神经网络不是图灵机,没有计算能力,无法准确地完成任何计算步骤

2. 世界是无穷复杂的(irreducible computation、NP 复杂度),而人类的理论都是简化的近似。AI 只能通过人类的简化理论来学习。

但是这些局限并不是不可逾越的,比如 function calling 就赋予了 AI 图灵机的能力。

关于第二点,涉及到 Polany's Paradox,人类无法描述世界的复杂性。这至少有两个理解方式:

1. 人类的语言没有客观标准,其意义由社会共识所决定

2. 世界的复杂性无法被理论描述

所以,GPT 的成功,实际上并不预示着计算能力的重大进步,而是人类能力的“巨大退步”。GPT 用事实证明了人类的语言能力并不是 irreducible computation,而是背后存在一些简单的规则,而且这个规则被 GPT 学会了。

然而作者也提到,GPT 的技术进步某种程度上只是无数人不断尝试的结果,人们发现通过一些设计能得到更好的结果。但是为什么要这么设计,GPT 是如何理解的?人们仍然一无所知。与其说人们发明了 GPT,也许说人类发现了 GPT 更为合适。

作者还试图构建一个大一统的计算语言,来抽象一切的事物,同时赋予 GPT 可解释性。我直观上觉得,这是否就是当年罗素的分析逻辑?

整理了一篇博客文章: https://blog.laisky.com/p/what-is-gpt/

原文笔记: https://laisky.notion.site/What-Is-ChatGPT-Doing-and-Why-Does-It-Work-6d390e2e44eb40498bd8b7add36bcc94?pvs=4

狗屁通套皮站支持 gpt-4-0125-preview 了。顺带提醒一下使用 one-api 套皮的人,升级最新的 one-api 后,在 设置->运营设置 里手动检查一下倍率设置,gpt-4-0125-preview 的价格应该和 gpt-4-1106-preview 一样设置为 5。升级后很可能遇到未设置 gpt-4-0125-preview 倍率的情况,此时倍率会按照默认 50 计费,导致计费错误。

https://youtu.be/eUdIz21P7zE?si=blnO07kmDngoBBC1

走访了几家 all-american chain 的公司,介绍美国制造业复兴的愿景。

几个有趣的观点:

1. free trade 是个骗局:美国人获得了更便宜的商品,但是输掉了未来。中国的工人生活也并没有变好。

2. decoupling from China 政策不是美国的单方面施暴,而只是对等措施。中国才是那个多年以来一直以脱钩为核心国策的国家。

3. 振兴制造业成为了两党共识,两党的争议在于谁做的更好

4. 美国对制造业危机的觉醒来自于疫情,连口罩都需要依赖中国进口。

5. 制造业的最后一人不会是赢家,而是最后的输家。我理解这句话是说制造业会不执迷于给人类手工保留职位,同时要考量自动化的进步。

片尾结语,不是所有人都想成为金融家或程序员,人们需要一个多样性的就业环境,创造价值。

走访了几家 all-american chain 的公司,介绍美国制造业复兴的愿景。

几个有趣的观点:

1. free trade 是个骗局:美国人获得了更便宜的商品,但是输掉了未来。中国的工人生活也并没有变好。

2. decoupling from China 政策不是美国的单方面施暴,而只是对等措施。中国才是那个多年以来一直以脱钩为核心国策的国家。

3. 振兴制造业成为了两党共识,两党的争议在于谁做的更好

4. 美国对制造业危机的觉醒来自于疫情,连口罩都需要依赖中国进口。

5. 制造业的最后一人不会是赢家,而是最后的输家。我理解这句话是说制造业会不执迷于给人类手工保留职位,同时要考量自动化的进步。

片尾结语,不是所有人都想成为金融家或程序员,人们需要一个多样性的就业环境,创造价值。

https://youtu.be/RFjAqth-EQk?si=2t6n0ybkfgkNrh6s

看了部关于 Nord Stream pipelines 爆炸案的纪录片,制作方是德国的 DW。

可以很明显地感受到,制片人基本上已经主观认定是乌克兰所为了。一个贴有乌克兰军人照片的护照持有者,租了一辆小游艇两个星期,这艘游艇足以实施这次袭击。而且,租借游艇的机构和金钱都来自于乌克兰。

但是,也有安全专家提示,你们这么轻易地调查就得出了这些线索,很可能是对方设下的圈套。比如故意留下乌克兰的蛛丝马迹,让你以为这是乌克兰所为。

而德国政府对北溪案件持严格保密态度,更让人怀疑是在故意隐瞒一些信息。

不过这案子难查的一个主要因素是,北溪管道实在太容易破坏了,甚至可以说任何一个有意向的组织,投入很少的资金,就可以完成。家庭作坊制造炸弹,能搞定 70 米海水的潜水员,租借一艘小游艇,足矣。

看了部关于 Nord Stream pipelines 爆炸案的纪录片,制作方是德国的 DW。

可以很明显地感受到,制片人基本上已经主观认定是乌克兰所为了。一个贴有乌克兰军人照片的护照持有者,租了一辆小游艇两个星期,这艘游艇足以实施这次袭击。而且,租借游艇的机构和金钱都来自于乌克兰。

但是,也有安全专家提示,你们这么轻易地调查就得出了这些线索,很可能是对方设下的圈套。比如故意留下乌克兰的蛛丝马迹,让你以为这是乌克兰所为。

而德国政府对北溪案件持严格保密态度,更让人怀疑是在故意隐瞒一些信息。

不过这案子难查的一个主要因素是,北溪管道实在太容易破坏了,甚至可以说任何一个有意向的组织,投入很少的资金,就可以完成。家庭作坊制造炸弹,能搞定 70 米海水的潜水员,租借一艘小游艇,足矣。

https://laisky.notion.site/What-We-Got-Right-What-We-Got-Wrong-4a44534fca40489eb2302161512e662b?pvs=4

Rob Pike 在 2023 年 11 月的一次内部演讲稿,回顾 Golang 14 年的历程,没什么技术内容,热爱 Golang 的人可以读一读。

Pike 强调发明 Go 是为了解决 Google 所面临的超大规模团队的工程问题。而在今天看来,有很多人批评 Go 的语法,却几乎没人批评 Go 的工程化能力,这可以看作初创者们的初衷已经圆满实现了。

因为 Google 内部使用 monorepo,导致初创团队对于依赖管理经验不足,也严重低估了其复杂性,所以早期 Go 是没有多版本依赖管理的,直到后来实现了 gomodule。

在并发问题上,Pike 再次推荐了经典论文 CSP,并且认为 async/await 的写法实际上是把复杂性交给了程序员。(我倒是觉得 async/await 在手写调度时实际上比 CSP 简单)

还有就是作者认为 interface 已经足够了,但是迫于社区压力引入了范型,范型和 interface 的兼容很成问题,为此付出了大量的努力。

关于 Golang 和 Google 的关系,Pike 总结为:the core Go team is paid by Google but they are independent。Google 付钱,但并不干涉,Golang 是完全由社区主导的。

BTW,Rob Pike 已经 68 岁了,据说已经退休,近年来已经很少露面。

Rob Pike 在 2023 年 11 月的一次内部演讲稿,回顾 Golang 14 年的历程,没什么技术内容,热爱 Golang 的人可以读一读。

Pike 强调发明 Go 是为了解决 Google 所面临的超大规模团队的工程问题。而在今天看来,有很多人批评 Go 的语法,却几乎没人批评 Go 的工程化能力,这可以看作初创者们的初衷已经圆满实现了。

因为 Google 内部使用 monorepo,导致初创团队对于依赖管理经验不足,也严重低估了其复杂性,所以早期 Go 是没有多版本依赖管理的,直到后来实现了 gomodule。

在并发问题上,Pike 再次推荐了经典论文 CSP,并且认为 async/await 的写法实际上是把复杂性交给了程序员。(我倒是觉得 async/await 在手写调度时实际上比 CSP 简单)

还有就是作者认为 interface 已经足够了,但是迫于社区压力引入了范型,范型和 interface 的兼容很成问题,为此付出了大量的努力。

关于 Golang 和 Google 的关系,Pike 总结为:the core Go team is paid by Google but they are independent。Google 付钱,但并不干涉,Golang 是完全由社区主导的。

BTW,Rob Pike 已经 68 岁了,据说已经退休,近年来已经很少露面。

https://chat.laisky.com/ 狗屁通套皮站可以跨设备同步所有的配置和对话记录了。

之前支持了各个会话保存独立的设置,这样就可以开一堆会话,然后通过 system prompt 给每个会话定义不同的角色。用起来虽然很爽,但是每个设备都得这么设置一次很烦,所以同步设置成了必要的。

现在可以通过 sync key 同步记录和设置,使用相同的 sync key 就可以拉取相同的记录,所有的记录在云上都使用 AES-256 加密,密钥就是 sync key,无需担心隐私。

Ps. 视频里出现的 sync key 我已经销毁了,不用费劲黑我了。

之前支持了各个会话保存独立的设置,这样就可以开一堆会话,然后通过 system prompt 给每个会话定义不同的角色。用起来虽然很爽,但是每个设备都得这么设置一次很烦,所以同步设置成了必要的。

现在可以通过 sync key 同步记录和设置,使用相同的 sync key 就可以拉取相同的记录,所有的记录在云上都使用 AES-256 加密,密钥就是 sync key,无需担心隐私。

Ps. 视频里出现的 sync key 我已经销毁了,不用费劲黑我了。

https://free-for.dev/#/ 免费 SaaS 服务索引,独立开发者的省钱宝典。

这站现在成我的日常娱乐了,有空就写几行垃圾代码,我自己用着舒服就行,缺啥加啥,哈哈哈哈。

next: https://t.me/laiskynotes/135

修电脑的后续,我高兴太早了,实际上并没修好,只不过出现了新的症状(最初刚升级 win11 时的症状)。

具体情况是,我修好后用了一天都没问题,让我以为修好了。但后来发现只要待机个五分钟后就会卡死。再后来发现不仅仅是待机,我在桌面上做一些轻度操作也会卡死,而我做一些需要大量 CPU 和磁盘 I/O 的操作就没事儿。然后我猜想是 win11 存在一些隐藏的省电策略,发现你负载低时就会触发,然后这个功能有致命 bug,会导致系统卡死。

基于这个猜想,我在 terminal 里跑了一个死循环,会稳定地吃掉一个核。然后奇迹发生了,这台 PC 从昨晚放置到现在都没死!

Ps. 我已经关闭了系统设置里所有的节能选项,sleep 全部设置为 never,power mode 为 best performance,但都没用。

BTW,我这台电脑外接了 UPS,所以在 OS 看来可能会误以为这是一台笔记本电脑,而 win11 在笔记本上的休眠死非常常见。今晚回去我把 UPS 拔掉试试。

补充:不是 win 的问题,是 CPU + 主板的问题。主板会自动调整 CPU 的电压,然后 CPU 在低电压时会卡死。

不知道为什么升级 win11 后立刻就出现了这个问题,可能是 win11 把我的主板 or CPU 驱动给静默升级了。

在 BIOS 设置里把 CPU 频率的 Auto 改成一个固定值就没问题了。

具体情况是,我修好后用了一天都没问题,让我以为修好了。但后来发现只要待机个五分钟后就会卡死。再后来发现不仅仅是待机,我在桌面上做一些轻度操作也会卡死,而我做一些需要大量 CPU 和磁盘 I/O 的操作就没事儿。然后我猜想是 win11 存在一些隐藏的省电策略,发现你负载低时就会触发,然后这个功能有致命 bug,会导致系统卡死。

基于这个猜想,我在 terminal 里跑了一个死循环,会稳定地吃掉一个核。然后奇迹发生了,这台 PC 从昨晚放置到现在都没死!

Ps. 我已经关闭了系统设置里所有的节能选项,sleep 全部设置为 never,power mode 为 best performance,但都没用。

补充:不是 win 的问题,是 CPU + 主板的问题。主板会自动调整 CPU 的电压,然后 CPU 在低电压时会卡死。

不知道为什么升级 win11 后立刻就出现了这个问题,可能是 win11 把我的主板 or CPU 驱动给静默升级了。

在 BIOS 设置里把 CPU 频率的 Auto 改成一个固定值就没问题了。