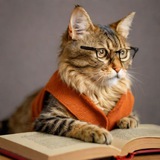

此前讨论过 passkey 的一个缺陷(https://t.me/laiskynotes/64 ),就是需要客户端存储太多数量的 resident keys,这对于如 Yubikey 这样的 security keys 设备非常不友好,因为消费级 security keys 往往只有 10~20 个 private key slots。

https://laisky.notion.site/HD-Wallets-Explained-From-High-Level-to-Nuts-and-Bolts-44d109ed89e04bb79f993234f185848e?pvs=4

最近学习了 Hierarchical Deterministic Keys 结构。HD Keys 本质上是一种面向非对称密钥的 KDF(key derivation function)。它可以从一个 root private key 为根节点,通过添加一些 key material 生成新的 child key。

KDF 是一个确定性(deterministic)的函数,也就是相同的输出,始终能得出一样的结果。这一概念对于熟悉 KMS 的人而言并不陌生,其实所有的 KMS 都是只存储 master key 的。HD Keys 的主要特点就是支持了非对称密钥。

那么我们是否可以把 HD 和 passkey 结合起来,让用户只需要存储一个(或多个,增强安全性)root key,然后服务端存储 key derivation materials,这样用户依然可以做到不同网站使用不同的 child key,而同时又不需要存储大量的 resident keys?

#crypto

https://laisky.notion.site/HD-Wallets-Explained-From-High-Level-to-Nuts-and-Bolts-44d109ed89e04bb79f993234f185848e?pvs=4

最近学习了 Hierarchical Deterministic Keys 结构。HD Keys 本质上是一种面向非对称密钥的 KDF(key derivation function)。它可以从一个 root private key 为根节点,通过添加一些 key material 生成新的 child key。

KDF 是一个确定性(deterministic)的函数,也就是相同的输出,始终能得出一样的结果。这一概念对于熟悉 KMS 的人而言并不陌生,其实所有的 KMS 都是只存储 master key 的。HD Keys 的主要特点就是支持了非对称密钥。

那么我们是否可以把 HD 和 passkey 结合起来,让用户只需要存储一个(或多个,增强安全性)root key,然后服务端存储 key derivation materials,这样用户依然可以做到不同网站使用不同的 child key,而同时又不需要存储大量的 resident keys?

#crypto

Azure OAI 的响应格式有变化,以前可以通过 choices 为空来判定对话已结束。而现在 azure oai 会首先返回一个 choices 为空的响应(只包含 content filters 结果),会导致老程序误判会话已结束。

你需要 skip 这些 empty response,然后把有内容的响应拼接起来。我的套皮站最近可能遇到会话卡住没有响应的问题,就是这个原因,已修复。

如果各位有 azure oai 项目发现响应突然变成空了可以排查下…

https://telegra.ph/Attention-Mechanism-02-21

简要概括下 RNN、attention、transformer 的关系。

next: https://t.me/laiskynotes/184

简要概括下 RNN、attention、transformer 的关系。

next: https://t.me/laiskynotes/184

很多人转这篇《最高人民法院:这份判决给软件开发者吃了定心丸》,稍微去看了下,感觉有点标题党。

原告基于 GPLv2 的开源项目二次开发了闭源商业软件,使用 socket/commandline 规避了 GPLv2 感染。被告窃取了原告的非开源商业代码,狡辩称这是 GPL 代码,可以使用。法院支持了原告的诉求,认定侵权事实成立。

侵权是发生于非开源商业代码,其实感觉和 GPLv2 没啥关系,又不是支持了开源代码的权利声明,而只是支持了软著的权利,没什么说服力,跟各位开源开发者也没什么关系。

https://youtu.be/WXuK6gekU1Y?si=KnJ-WTTVCpgvEgT3

前阵子和人讨论 GPT 时聊到了 AlphaGo,我意识到我对 AlphaGo 不太了解,所以最近打算学习一下。而要了解 AlphaGo,首先都推荐观看这部纪录片。

2014 年深度学习(AlexNet)的论文发表,DeepMind 开始利用深度神经网络处理视频游戏,并很快转向了对围棋的研究。2015 年,DeepMind 邀请欧洲围棋冠军 Fan Hui 来到英国与 AlphaGo 对弈并全胜,这是围棋程序第一次战胜专业人类选手,Fan Hui 也以顾问的身份加入 AlphaGo。2016 年 DeepMind 前往韩国挑战世界冠军 Lee Sedol,并取得了四胜一负的成绩。这一系列的胜利引起了全球的关注,也让人们开始认识到了深度学习的威力。

值得注意的是,围棋的特色在于其近乎无穷的可能性,这也对应着近乎无穷的计算量,这使得围棋其实是一个直觉游戏(intuitive game),而不是一个需要深思熟虑的策略游戏(logic based game),毕竟任何所谓的深思熟虑在这无穷的可能性面前都是无谓的。专业棋手其实是通过记忆数以万计的棋谱来训练自己的直觉,然后使用直觉来对弈,这一训练方式和神经网络的工作原理非常相似,这也是深度神经网络最终能够击败人类的原因。

更多关于神经网络信息可以参考此前发过的介绍 GPT 的文: https://t.me/laiskynotes/144

我还在学习 AlphaGo 的论文,更多笔记日后再更新。

前阵子和人讨论 GPT 时聊到了 AlphaGo,我意识到我对 AlphaGo 不太了解,所以最近打算学习一下。而要了解 AlphaGo,首先都推荐观看这部纪录片。

2014 年深度学习(AlexNet)的论文发表,DeepMind 开始利用深度神经网络处理视频游戏,并很快转向了对围棋的研究。2015 年,DeepMind 邀请欧洲围棋冠军 Fan Hui 来到英国与 AlphaGo 对弈并全胜,这是围棋程序第一次战胜专业人类选手,Fan Hui 也以顾问的身份加入 AlphaGo。2016 年 DeepMind 前往韩国挑战世界冠军 Lee Sedol,并取得了四胜一负的成绩。这一系列的胜利引起了全球的关注,也让人们开始认识到了深度学习的威力。

值得注意的是,围棋的特色在于其近乎无穷的可能性,这也对应着近乎无穷的计算量,这使得围棋其实是一个直觉游戏(intuitive game),而不是一个需要深思熟虑的策略游戏(logic based game),毕竟任何所谓的深思熟虑在这无穷的可能性面前都是无谓的。专业棋手其实是通过记忆数以万计的棋谱来训练自己的直觉,然后使用直觉来对弈,这一训练方式和神经网络的工作原理非常相似,这也是深度神经网络最终能够击败人类的原因。

更多关于神经网络信息可以参考此前发过的介绍 GPT 的文: https://t.me/laiskynotes/144

我还在学习 AlphaGo 的论文,更多笔记日后再更新。

https://youtu.be/EpMLAQbSYAw?si=t5IxWdWqSh0S9szH

《Age of Easy Money》对美国近数十年来的 easy money 政策的反思。

自次贷危机后,美国联邦储备局(FED)实行了大规模的量化宽松政策(Quantitative Easing, QE),即疯狂印钞,为大银行注资使其免于倒闭,这一政策在当年也被称为 Too Big to Fail。

这一政策的指导思想是政府可以在短期上发挥对经济的逆调控作用,当经济下行时,可以通过 QE 为市场注入血液;当经济过热时,可以通过加息来收紧货币。但是从过去二十年的经历来看,FED 的 QE 政策实际上无限制地鼓励了投机客的冒险行为,一旦大型投机客因为投机失败导致资金链紧张,FED 就会通过 QE 为其注资。这种政策导致了市场的不断泡沫化,也导致了美国经济的不断失衡。

更糟糕的是,如今回顾过去数十年的量化宽松,虽然为市场注入了大量低息甚至零息贷款,但是这些贷款并没有流入实体经济和基础设施,事实上几乎没有为美国带来任何实质性的建设。这些钱的很大部分实际上在金融市场空转,各个机构互相购买债券,互相借贷,互相投机,一场狂欢过后,除了通胀什么也没剩下。这也是当时美国人反感银行业,反对华尔街的主要原因之一,华尔街拿了 FED 救市的钱,却只管套利,而不是为美国经济做出实质性的贡献。这在片尾被称为“美国的政治缺陷,FED 可以印钞,却无法决定怎么花掉这些钱,华尔街可以花这些钱,但是华尔街的唯一目标就是套利”。

最后,Easy Money 的狂欢时代终将结束,接下来可能泡沫破灭的漫长回调。

《Age of Easy Money》对美国近数十年来的 easy money 政策的反思。

自次贷危机后,美国联邦储备局(FED)实行了大规模的量化宽松政策(Quantitative Easing, QE),即疯狂印钞,为大银行注资使其免于倒闭,这一政策在当年也被称为 Too Big to Fail。

这一政策的指导思想是政府可以在短期上发挥对经济的逆调控作用,当经济下行时,可以通过 QE 为市场注入血液;当经济过热时,可以通过加息来收紧货币。但是从过去二十年的经历来看,FED 的 QE 政策实际上无限制地鼓励了投机客的冒险行为,一旦大型投机客因为投机失败导致资金链紧张,FED 就会通过 QE 为其注资。这种政策导致了市场的不断泡沫化,也导致了美国经济的不断失衡。

更糟糕的是,如今回顾过去数十年的量化宽松,虽然为市场注入了大量低息甚至零息贷款,但是这些贷款并没有流入实体经济和基础设施,事实上几乎没有为美国带来任何实质性的建设。这些钱的很大部分实际上在金融市场空转,各个机构互相购买债券,互相借贷,互相投机,一场狂欢过后,除了通胀什么也没剩下。这也是当时美国人反感银行业,反对华尔街的主要原因之一,华尔街拿了 FED 救市的钱,却只管套利,而不是为美国经济做出实质性的贡献。这在片尾被称为“美国的政治缺陷,FED 可以印钞,却无法决定怎么花掉这些钱,华尔街可以花这些钱,但是华尔街的唯一目标就是套利”。

最后,Easy Money 的狂欢时代终将结束,接下来可能泡沫破灭的漫长回调。

话说前阵子每晚和家人吃晚饭时重看了火影忍者《Naruto》的主线剧情(700 集为止),也算是了却一个童年(青年?)时代的情怀。

实际上岸本齐史的剧本还是很有功底的,我觉得有一些值得称赞的地方:

1. 全剧没有精神失常的反派,甚至于没有严格意义上的反派。所有人都是出于自己的境遇,做出了自以为最好的选择。

2. 战力基本没有通货膨胀,至少 700 集以前基本维持了战力的平衡。

3. 这是一部基片,所有的 CP 都被拆了(甚至包括路人配角的夫妇),没有建立任何男女角色的感情线。(所有的感情线都是 700 集以后硬加的)。而且很容易看出来,作者不知道除了跪舔以外的男女关系…

4. 作者是个弟/兄控,每个人都有个深爱的兄弟。鼬对佐助的爱情表白在最后几十集里重放了大概有十次。

5. 鸣人感觉是个双相情感障碍

Ps. 哥哥早已洞察了一切,伊莲老师看完后去买了件鼬的体恤…

实际上岸本齐史的剧本还是很有功底的,我觉得有一些值得称赞的地方:

1. 全剧没有精神失常的反派,甚至于没有严格意义上的反派。所有人都是出于自己的境遇,做出了自以为最好的选择。

2. 战力基本没有通货膨胀,至少 700 集以前基本维持了战力的平衡。

3. 这是一部基片,所有的 CP 都被拆了(甚至包括路人配角的夫妇),没有建立任何男女角色的感情线。(所有的感情线都是 700 集以后硬加的)。而且很容易看出来,作者不知道除了跪舔以外的男女关系…

4. 作者是个弟/兄控,每个人都有个深爱的兄弟。鼬对佐助的爱情表白在最后几十集里重放了大概有十次。

5. 鸣人感觉是个双相情感障碍

Ps. 哥哥早已洞察了一切,伊莲老师看完后去买了件鼬的体恤…

在美剧《The Newsroom》第一季的第一集里有一个经典片段,主角 Will McAvoy 抛出了一大段“惊世骇俗”的关于舆论误人和教化世人的理想。

我个人觉得,在美国的大牌主持人中,形象最接近 Will 这个理想的就当属囧司徒(Jon Stewart)了。尤其是他前些年在 Apple Tv 上主持的《The Problem With Jon Stewart》,非常深刻尖锐地揭露和讽刺美国当下的社会问题,每集挑选一个矛盾点,广泛采访各方的实权人士,然后用幽默辛辣的嘉宾对谈将这些问题揭露得淋漓尽致。

尤其是因为 Jon Stewart 的地位和影响力,他真的能直接访谈到那些手握大权的重要人物。这和 Youtube 上那些小成本纪录片经常被实权人物吃闭门羹完全不同,你能直接听到这些事情在最初的计划者眼中是如何被诠释的。

尤其重点讲述了 2020 年 5 月 30 日年龙飞船首次载人飞行的背后故事。这是自 2011 年 7 月 20 日 Atlantis 号航天飞机执行完 STS-135 号任务后,美国终于再次具备载人航天能力。(龙飞船的乘员中就有 STS-135 的成员)

希望能早日看到人类重归月球,甚至登陆火星。就算 Musk 有一万个缺点,但是空间探索的这个人类的边境上,这世上多如牛毛的富豪,确实只有他在拓展人类的疆域。

当主角学会了七肢桶的语言后,就觉醒了时空意识。这也是为什么她会对女儿的死无动于衷,因为所有的事情都会发生,你只是观察到了时空的一个切面。

但这并不是说平行时空或世界线,因为不同事件的发生概率是不一样的。这个概率不是用来区分必然性和偶然性(所有事情都是必然),而是用来计算和结局的相似度,最相似的概率会作为过程显现出来。光会遍历所有的路径,但是你只能观测到最短路径。然而它确实遍历了所有的路径,因为你能观测到干涉现象。

电影《降临 Arrival》是完全背离了原著的内涵的,如果你要理会我在这里探讨的事情,需要阅读一下原著,而不是电影。我曾经对电影写过一篇恶评: https://movie.douban.com/subject/21324900/

next: https://t.me/laiskynotes/149

https://laisky.notion.site/Aligning-language-models-to-follow-instructions-0a1a1aca07174ad09b1cee55d4856b4f?pvs=4

经常在大模型领域听到 aligning(拉通对齐)这个词,此文就介绍了究竟是什么意思。

这个对齐指的是让 LLM 的输出,和用户的期望对齐。这是个很宽泛的描述,包括:

1. 遵循用户的指令

2. 遵循事实

3. 不要包含恶意信息

而实现对齐的方法为:

1. 找一群活人充当 labelers,编写参考回答,同时也为模型输出评分

2. 用 labelers 编写的回答来 fine-tuning 模型

3. 用 labelers 的打分数据,去训练一个 Reward Model

4. 用 Reward Model 对 LLM 进行强化学习

这套流程称为真人反馈强化学习(reinforcement learning from human feedback, RLHF)

最终得到的新模型,称为 InstructGPT,这个模型可以用缩小 100 倍的参数量,实现更好的输出。

GPT-3 本来有 175B 个参数,而 InstructGPT 只有 1.3B。这就是为什么 GPT 可以实现性能飞跃和大幅降价的原因,也就是后续的 turbo 模型。

Ps. 奇了怪了,我记得去年 Azure 透露 GPT 只有 2B 参数时还有一大群人震惊,其实 OpenAI 在这篇 2022 年 1 月的文章里就说了只有 1.3B 参数。

经常在大模型领域听到 aligning(拉通对齐)这个词,此文就介绍了究竟是什么意思。

这个对齐指的是让 LLM 的输出,和用户的期望对齐。这是个很宽泛的描述,包括:

1. 遵循用户的指令

2. 遵循事实

3. 不要包含恶意信息

而实现对齐的方法为:

1. 找一群活人充当 labelers,编写参考回答,同时也为模型输出评分

2. 用 labelers 编写的回答来 fine-tuning 模型

3. 用 labelers 的打分数据,去训练一个 Reward Model

4. 用 Reward Model 对 LLM 进行强化学习

这套流程称为真人反馈强化学习(reinforcement learning from human feedback, RLHF)

最终得到的新模型,称为 InstructGPT,这个模型可以用缩小 100 倍的参数量,实现更好的输出。

GPT-3 本来有 175B 个参数,而 InstructGPT 只有 1.3B。这就是为什么 GPT 可以实现性能飞跃和大幅降价的原因,也就是后续的 turbo 模型。

Ps. 奇了怪了,我记得去年 Azure 透露 GPT 只有 2B 参数时还有一大群人震惊,其实 OpenAI 在这篇 2022 年 1 月的文章里就说了只有 1.3B 参数。

有兴趣的话可以评论区讨论。

这不是民科,而是基于所有已知科学理论和事实,对未知进行的合理推测。

实际上我认为这是除了照顾好自己外最重要的事情,寻求对宇宙的理解。

---

无论是量子世界的叠加态,还是费曼的路径积分,似乎都预示了这么一个世界:

一切可能发生的事情都会发生,结果赋予过程以意义,事件概率不是发生的概率,而是其显现的概率。

所以观察者对于世界是无关紧要的,观察者只是让世界以观察者的方式现形。

---

所以你犹豫或者焦虑一件事要不要发生是没任何意义的,所有的事情都会发生。

光永远走最短路径,不是长的路径它不走,其实光遍历了所有的路径,不然双缝干涉就不会存在。

所有的事件都会发生,但是在某一时刻只有一个事件会显形,这是由观察者的结局反推回去的所有的概率重合事件。

---

人们喜欢说“经历比结果重要”。

但是这个世界的物理基础不是这样的,经历是最不重要的,你其实经历了一切。结果是唯一重要的,一切的经历都是从结果反推而呈现的。

宇宙的观察者毫无意义,哪怕不同的观察者看到了完全不同的宇宙,宇宙也还是那个宇宙。

---

能量在空间上展开时会出现对称性破损,构成基本力和物质。

物质在时间上展开时也会出现对称性破损,成为热力学第二定律。

意识的存在意义是在无所不包的时空混沌中勾勒出一条轨迹。意识的某个必然结局可以反推出一整个发展轨迹。

一个水分子在海洋中的路径,这就是你我全部的人生。

---

产生了一个奇思妙想:

给一个物体施加加速度,可以阻碍它在时间上的展开程度,因为它在一段连续的时间内都持续获得能量。

这在宏观上就表现为时间压缩,持续获得加速度的物体的时间流逝会比其他物体更慢一些。

毕竟时间根本就不存在,只是意识的存在性幻觉。意识就是时间的方向性的表现形式。

next: https://t.me/laiskynotes/147

最近几天都在读这篇文章,作者是大名鼎鼎的 Stephen Wolfram,就是创建数学软件 Wolfram 的那位。

此文从 GPT 开始谈起,实际上回溯了神经网络的主线发展历程,从最基础的权重计算,讲到 n-grams 最终到 transformer 的 attention 机制。

虽然我多年前就学习过神经网络,但是有很多细节更多的是知其然不知其所以然,这篇文章读来让我有醍醐灌顶的感觉,把关键的部分的意义都讲清楚了。

作者还很清晰地阐述了神经网络的几个天然局限,这是人脑能轻松做到而神经网络只能望洋兴叹的:

1. 神经网络不是图灵机,没有计算能力,无法准确地完成任何计算步骤

2. 世界是无穷复杂的(irreducible computation、NP 复杂度),而人类的理论都是简化的近似。AI 只能通过人类的简化理论来学习。

但是这些局限并不是不可逾越的,比如 function calling 就赋予了 AI 图灵机的能力。

关于第二点,涉及到 Polany's Paradox,人类无法描述世界的复杂性。这至少有两个理解方式:

1. 人类的语言没有客观标准,其意义由社会共识所决定

2. 世界的复杂性无法被理论描述

所以,GPT 的成功,实际上并不预示着计算能力的重大进步,而是人类能力的“巨大退步”。GPT 用事实证明了人类的语言能力并不是 irreducible computation,而是背后存在一些简单的规则,而且这个规则被 GPT 学会了。

然而作者也提到,GPT 的技术进步某种程度上只是无数人不断尝试的结果,人们发现通过一些设计能得到更好的结果。但是为什么要这么设计,GPT 是如何理解的?人们仍然一无所知。与其说人们发明了 GPT,也许说人类发现了 GPT 更为合适。

作者还试图构建一个大一统的计算语言,来抽象一切的事物,同时赋予 GPT 可解释性。我直观上觉得,这是否就是当年罗素的分析逻辑?

整理了一篇博客文章: https://blog.laisky.com/p/what-is-gpt/

原文笔记: https://laisky.notion.site/What-Is-ChatGPT-Doing-and-Why-Does-It-Work-6d390e2e44eb40498bd8b7add36bcc94?pvs=4

此文从 GPT 开始谈起,实际上回溯了神经网络的主线发展历程,从最基础的权重计算,讲到 n-grams 最终到 transformer 的 attention 机制。

虽然我多年前就学习过神经网络,但是有很多细节更多的是知其然不知其所以然,这篇文章读来让我有醍醐灌顶的感觉,把关键的部分的意义都讲清楚了。

作者还很清晰地阐述了神经网络的几个天然局限,这是人脑能轻松做到而神经网络只能望洋兴叹的:

1. 神经网络不是图灵机,没有计算能力,无法准确地完成任何计算步骤

2. 世界是无穷复杂的(irreducible computation、NP 复杂度),而人类的理论都是简化的近似。AI 只能通过人类的简化理论来学习。

但是这些局限并不是不可逾越的,比如 function calling 就赋予了 AI 图灵机的能力。

关于第二点,涉及到 Polany's Paradox,人类无法描述世界的复杂性。这至少有两个理解方式:

1. 人类的语言没有客观标准,其意义由社会共识所决定

2. 世界的复杂性无法被理论描述

所以,GPT 的成功,实际上并不预示着计算能力的重大进步,而是人类能力的“巨大退步”。GPT 用事实证明了人类的语言能力并不是 irreducible computation,而是背后存在一些简单的规则,而且这个规则被 GPT 学会了。

然而作者也提到,GPT 的技术进步某种程度上只是无数人不断尝试的结果,人们发现通过一些设计能得到更好的结果。但是为什么要这么设计,GPT 是如何理解的?人们仍然一无所知。与其说人们发明了 GPT,也许说人类发现了 GPT 更为合适。

作者还试图构建一个大一统的计算语言,来抽象一切的事物,同时赋予 GPT 可解释性。我直观上觉得,这是否就是当年罗素的分析逻辑?

整理了一篇博客文章: https://blog.laisky.com/p/what-is-gpt/

原文笔记: https://laisky.notion.site/What-Is-ChatGPT-Doing-and-Why-Does-It-Work-6d390e2e44eb40498bd8b7add36bcc94?pvs=4